La forma en que buscamos en la web está cambiando, por lo que la Búsqueda de Google también está cambiando

Desde sus inicios, el motor de búsqueda de Google ha ofrecido una interfaz de usuario simple: escriba su consulta de búsqueda en un cuadro y podrá averiguar lo que Internet tiene para ofrecerle. Los resultados se entregan en gran medida en forma de texto azul, con hipervínculos a otros sitios. En los últimos años, los resultados se han actualizado con resultados visuales, noticias relacionadas y otras formas de contenido relacionado.

Aun así, la propia investigación interna de Google ha demostrado que una parte significativa de los usuarios de Internet más jóvenes prefieren buscar información en redes sociales apps, como Instagram y TikTok, sobre los productos de Google. Esas preferencias de usuario en evolución ayudan a explicar por qué Google está desarrollando sus herramientas de búsqueda básicas para incluir formas de comunicación más multimodales e incluir información de fuentes más "auténticas", como publicaciones en redes sociales.

"La forma en que las personas buscan y escriben información nunca estuvo destinada a limitarse a escribir palabras", dijo Cathy Edwards, vicepresidenta de Google y gerente general de búsqueda, a los periodistas antes del evento Search On de Google el miércoles. "Hay tanta información en la web que viene en diferentes formatos y de diferentes voces que tienen diferente autoridad y experiencia".

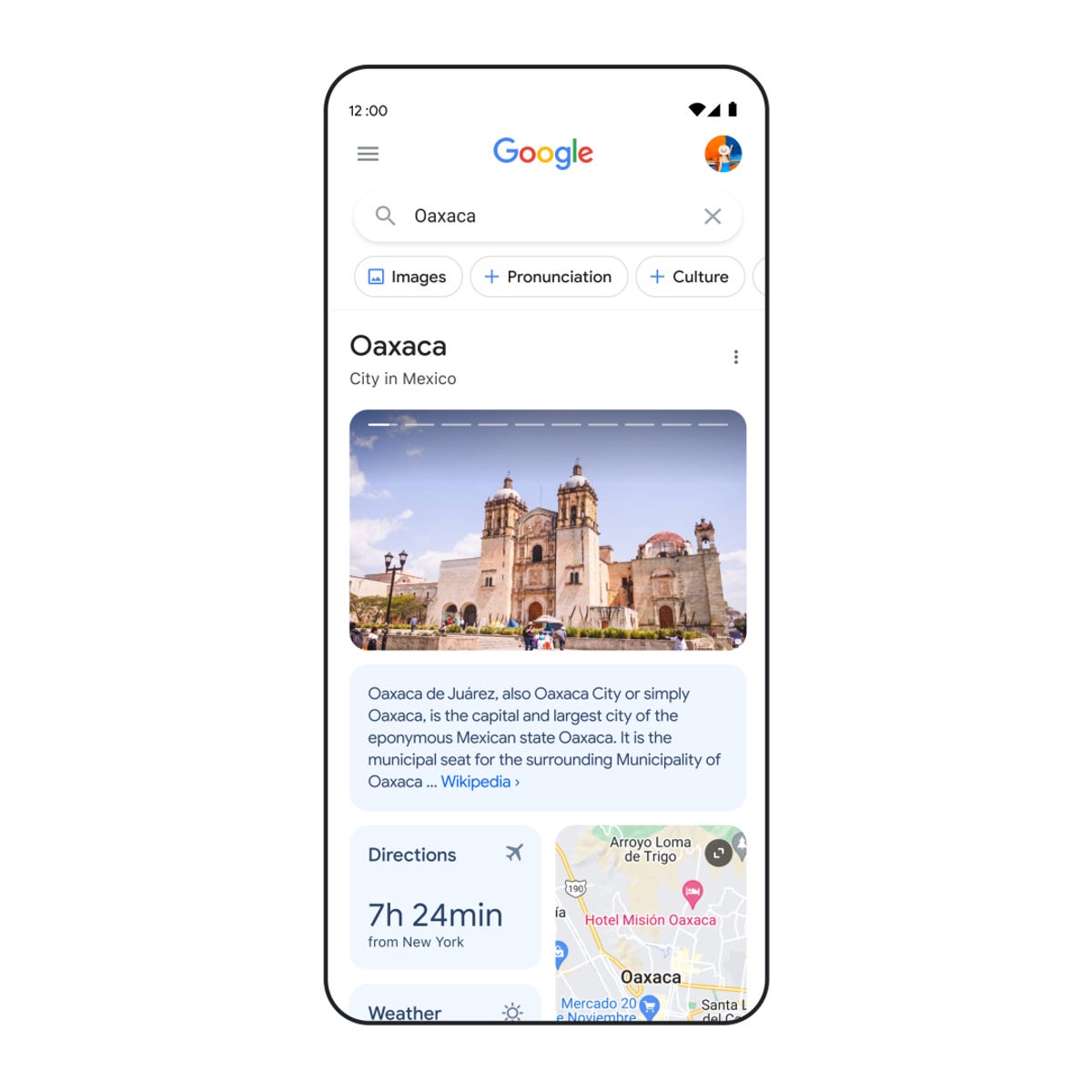

Durante el evento del miércoles, Google anunció que presentará a los usuarios de búsqueda contenido de "creadores en la web abierta". Si un usuario busca el nombre de una ciudad específica, por ejemplo, puede obtener resultados que incluyen historias visuales y videos cortos de personas que han visitado ese lugar.

“Realmente podemos ver, a medida que ingresamos en esta nueva era de búsqueda, que podrá encontrar exactamente lo que está buscando al combinar imágenes, sonidos, texto y voz, organizados de una manera que tenga sentido para usted. dijo Edwards. “Y eso, en última instancia, te ayuda a dar sentido al mundo”.

Edwards reconoció que “hay contenido realmente bueno” en TikTok, ya que ha reducido las barreras de entrada para la creación de contenido. “Estamos buscando más formas de incluir eso en nuestros resultados de búsqueda”, dijo.

La "nueva era de búsqueda" de Google también incluye un mayor énfasis en las conversaciones dirigidas por la comunidad en foros como Reddit, otra plataforma que sirve como alternativa a la Búsqueda de Google. Google está lanzando una nueva función en la Búsqueda llamada Discusiones en foros que brinda esos resultados.

“Hay personas que obviamente están ansiosas por ver más resultados de Reddit y otros foros comunitarios en nuestros resultados”, dijo Edwards. “Fundamentalmente, se trata solo de darles a las personas lo que quieren, cuándo y qué les resulta más útil cuando acuden a nosotros”.

Al mismo tiempo, Edwards dijo que Google se enfoca en garantizar que los usuarios puedan encontrar "tanto la información auténtica como la información fidedigna" en sus herramientas de búsqueda.

“También vemos en nuestra investigación que las personas acuden a Google específicamente para verificar sus afirmaciones y… para ayudarlos a decidir si quieren creer algo que podrían haber encontrado en un feed social”, dijo. “Realmente confían en que podrán encontrar información de alta calidad en Google, y creo que eso también es muy importante”.

El mayor enfoque de Google en la búsqueda multimodal no se trata solo de los resultados, sino también de cómo las personas pueden hacer preguntas.

A principios de este año, Google introdujo la búsqueda múltiple en versión beta, lo que permite a los usuarios buscar un tema usando imágenes y texto simultáneamente. Ahora, en los próximos meses, Google ampliará esa capacidad a más de 70 idiomas.

Mientras tanto, Google también está mejorando sus capacidades de Lens. La gente ya usa Google para traducir texto en imágenes más de mil millones de veces al mes, en más de 1 idiomas. Ahora, si apunta su cámara a una imagen con texto, Lens podrá traducir el texto y superponer el texto traducido en las imágenes debajo. Por ejemplo, si está leyendo la etiqueta de una bolsa de papas fritas, el texto aparecerá en su idioma preferido en esa bolsa de papas fritas.

“En lugar de cubrir el texto original, lo borramos y luego reconstruimos los píxeles debajo con un fondo generado por IA”, explicó Edwards. “Y luego superponemos el texto traducido encima de la imagen. Así que realmente se siente como si estuvieras mirando el paquete de ese producto con el texto traducido”. Esta función se lanzará a finales de este año.